-

Audit Financial Services

Mehr Sicherheit, mehr Vertrauen: Wirtschaftsprüfung für Banken und andere Finanzunternehmen

-

Audit Industry, Services, Institutions

Mehr Sicherheit, mehr Vertrauen: Wirtschaftsprüfungen für nationale und internationale Geschäftskunden

-

Corporate Tax

Nationale und internationale Steuerberatung und -planung

-

Individual Tax

Individual Tax

-

Indirect Tax/VAT

Unsere Dienstleistungen im Bereich Mehrwertsteuer

-

Transfer Pricing

Verrechnungspreise

-

M&A Tax

Mergers & Acquisitions Steuern – Beratung über den gesamten Transaktionszyklus

-

Tax Financial Services

Tax Financial Services

-

Financial Services

Beratung Finanzindustrie

-

Advisory IT & Digitalisation

Vermittlung von Sicherheit aus der IT.

-

Forensic Services

Heutzutage geht es bei der Aufklärung von Straftaten in Unternehmen immer häufiger auch um digitale Daten und ganze IT-Systeme.

-

Regulatory & Compliance Financial Services

Beratungsdienstleistungen im Bereich Finanzmarktrecht.

-

Transaction Services / Mergers & Acquisitions

Gut beraten Transaktionen erfolgreich abwickeln.

-

Legal Services

Persönliche Beratung, die Ihnen Recht gibt.

-

Trust Services

Ihr zuverlässiger Partner in Sachen Vermögensplanung, Trusts und Stiftungen.

-

Business Risk Services

Nachhaltiges Wachstum für Ihr Unternehmen.

-

Abacus

Grant Thornton Schweiz Liechtenstein ist seit 2020 offizieller Vertriebspartner der Abacus Business Software.

-

Accounting Services

Buchführung ist für uns weit mehr als die Verarbeitung von Zahlen.

-

Payroll Services

Monat für Monat sparen Sie Zeit und Energie, wenn Sie wissen, dass Ihre komplette Lohnadministration sich in den besten Händen befindet.

-

Real Estate Management

Geben Sie Ihrem kompletten Immobilienmanagement ein sicheres Zuhause.

-

Lernende

Karriere mit Lehre?!

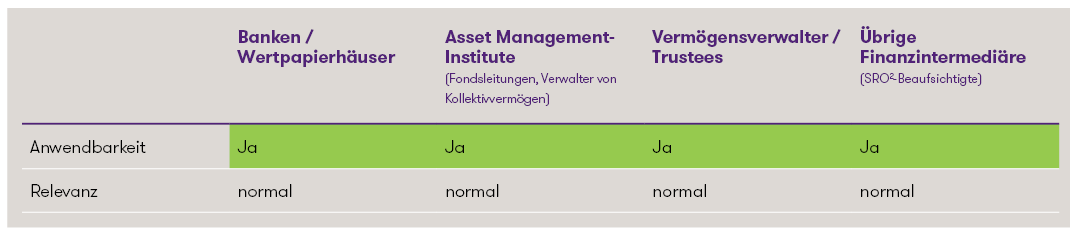

Einordnung1

1 Es handelt sich um eine stark vereinfachte Darstellung, welche eine rasche erste Einordnung der Thematik ermöglichen soll. Jedes Institut sollte die Relevanz und den konkreten Handlungsbedarf individuell-konkret bestimmen.

Künstliche Intelligenz im Schweizer Finanzmarkt

In der Schweiz hat der Bundesrat am 22. November 2023 entschieden, die Basis einer zukünftigen KI-Regulierung zu schaffen. Das UVEK wurde beauftragt, bis Ende 2024 mögliche Ansätze zur Regulierung von KI in der Schweiz zu identifizieren, wobei diese mit den regulatorischen Entwicklungen in der EU kompatibel sein sollten.

Gerade auch in der Finanzindustrie ist die Bedeutung von KI in jüngster Zeit stark angestiegen. Die Fülle an Einsatzgebieten von KI ist im Bereich der Finanzdienstleistungen riesig. Die FINMA hat KI in ihrem Risikomonitor 2023 als längerfristigen Trend aber auch als strategisches Risiko identifiziert. Dabei hat sie angekündigt, den Einsatz von KI bei beaufsichtigten Instituten zu prüfen und die weiteren Entwicklungen im In- und Ausland parallel dazu eng mitzuverfolgen. Konkret wurden die folgenden vier Erwartungen an Finanzdienstleister beim Einsatz von KI formuliert:

- Governance und Verantwortlichkeit: Es seien klare Rollen und Verantwortlichkeiten sowie Risikomanagementprozesse zu definieren. Die Verantwortung für Entscheidungen können nicht an KI oder Drittparteien delegiert werden. Alle Beteiligten müssen über genügend Know-how im Bereich KI verfügen.

- Robustheit und Zuverlässigkeit: Bei der Entwicklung, der Anpassung und in der Anwendung von KI sei sicherzustellen, dass die Ergebnisse genau, robust und zuverlässig seien.

- Transparenz und Erklärbarkeit: Die Erklärbarkeit der Resultate einer KI-Anwendung sowie die Transparenz über deren Einsatz seien je nach Empfänger, Relevanz und Prozessintegration sicherzustellen.

- Gleichbehandlung: Nicht begründbare Ungleichbehandlungen verschiedener Personengruppen seien zu vermeiden.

EU-Regulierung zur Künstlichen Intelligenz (KI Verordnung)

Mit dem politischen Kompromiss der Europäischen Kommission, dem Rat der Europäischen Union und dem Europäischen Parlament vom 8. Dezember 2023 machte die EU einen grossen Schritt in Richtung KI-Gesetzgebung. Zur Definition eines KI-Systems greifen die EU-Gesetzgeber auf die Arbeiten der OECD zurück, wobei für die genaue Definition die finale Fassung der KI-Verordnung abzuwarten bleibt. Die OECD definiert ein KI-System als ein «machine-based system that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments».

Die KI-Verordnung wird basierend auf den potentiellen Risiken gegenüber der Gesellschaft und den Grundrechten eine risikobasierte Klassifizierung der verschiedenen KI-Systeme enthalten. Es wird zwischen den folgenden Risikostufen unterschieden:

- Systeme mit einem inakzeptablen Risiko

Systeme, welche Grundrechte verletzen, stellen ein unannehmbares Risiko dar und werden daher verboten. Dazu gehören beispielsweise staatliche Social-Scoring-Systeme oder Echtzeit biometrische Identifikationssysteme im öffentlichen Raum.

- Systeme mit hohem Risiko

Systeme, bei welchen ein erhebliches Risiko besteht, dass sie Sicherheit und Grundrechte von Personen beeinträchtigen könnten. In diese Kategorie werden Systeme fallen, welche in sensiblen Bereichen wie kritischer Infrastruktur oder Bildung eingesetzt werden. Diese Systeme unterliegen strengen Anforderungen (Konformitätsbewertung, Prüfung der Grundrechtsbeeinträchtigung, etc.).

- Systeme mit beschränktem Risiko

Systeme, bei denen nur beschränkte Risiken bestehen, werden gewissen Offenlegungspflichten unterstellt. In diese Kategorie fallen beispielsweise «Chatbots» oder «Deepfakes». Diese Systeme erfordern eine transparente Information an die Nutzer, dass sie mit einem KI-System interagieren. - Systeme mit keinem oder minimalem Risiko

Systeme, die keine oder nur minimale Risiken für die Gesellschaft darstellen wie beispielsweise KI-gesteuerte Spam-Filter. In diese Kategorie sollten die meisten KI-Systeme fallen. Zwar werden für diese Systeme keine spezifischen Pflichten eingeführt, jedoch können Anbieter freiwillig einen Code of Conduct einhalten.

Neben diesen 4 Risikokategorien werden mit der KI-Verordnung spezifische Dokumentations- und Transparenzpflichten für sog. General-Purpose AI (GPAI)-Modelle eingeführt. Um die Beurteilung der Konformität verschiedener Aspekte der KI-Verordnung zu standardisieren, ist vorgesehen, dass die Einhaltung vermutet wird, wenn harmonisierte technische Normen eingehalten werden. Die Erarbeitung derartiger Normen bis 2025 wurde von der Europäischen Kommission bereits in Auftrag gegeben.

Ähnlich wie im Datenschutzrecht werden hohe Geldbussen für Verstösse gegen KI-Vorschriften vorgesehen sein, welche je nach Schwere und Art des Verstosses bis zu EUR 35 Mio. bzw. 7% des weltweiten Jahresumsatzes betragen können. Die Umsetzungsarbeiten sind in Arbeit und die finale Fassung der KI-Verordnung wird im Q1 2024 erwartet. Der Erlass wird voraussichtlich zwei Jahre nach Verabschiedung in Kraft treten.

Aufgrund des extraterritorialen Anwendungsbereichs wird die KI-Verordnung auch Anwendung auf Schweizer Unternehmen finden, i) welche ein KI-System in der EU in Verkehr bringen, ii) deren KI-System in der EU genutzt wird, oder iii) bei welchen sich der Output des KI-Systems auf Menschen in der EU auswirkt, indem diese von der Verwendung des KI-Systems betroffen sind.

Fazit

Schweizer Finanzdienstleister, welche KI-Systeme in ihren Produkten und Dienstleistungen einsetzen oder einzusetzen beabsichtigen, sollten sich mit den diesbezüglichen Erwartungen der FINMA und mit der finalen Fassung der KI-Verordnung der EU auseinandersetzen und dabei genau überprüfen, inwiefern die betreffenden Vorschriften zur Anwendung gelangen und wie sie angemessen umgesetzt werden können.

Haben Sie Fragen zur AI-Regulierung? Gerne unterstützen Sie unsere Spezialisten vom Regulatory & Compliance FS Team. Wir freuen uns auf Ihre Kontaktaufnahme.